LeCun离职后不止创一份业!押注与大模型不同的路线,加入硅谷初创董事会

LeCun离职后不止创一份业!押注与大模型不同的路线,加入硅谷初创董事会离开Meta这座围城后,Yann LeCun似乎悟了“不要把鸡蛋装在同一个篮子里”。一边,他亲手打造了自己的初创公司AMI,试图在世界模型这条赛道上大展拳脚;同时,他的目光又投向了硅谷的另一角。

离开Meta这座围城后,Yann LeCun似乎悟了“不要把鸡蛋装在同一个篮子里”。一边,他亲手打造了自己的初创公司AMI,试图在世界模型这条赛道上大展拳脚;同时,他的目光又投向了硅谷的另一角。

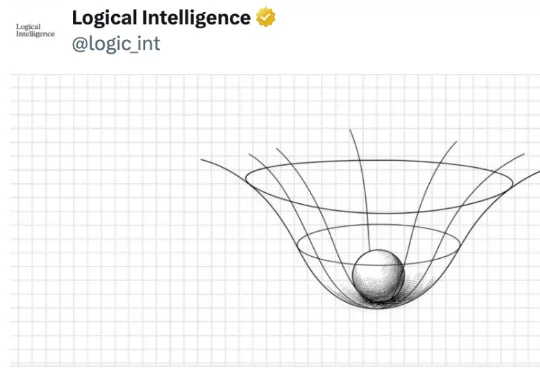

真正的挑战在于,如何在错综复杂的原始视觉输入中提取抽象精髓。这便引出了本研究的主角:JEPA-WM(联合嵌入预测世界模型)。从名字也能看出来,这个模型与 Yann LeCun 的 JEPA(联合嵌入预测架构)紧密相关。事实上也确实如此,并且 Yann LeCun 本人也是该论文的作者之一。

知名AI 科学家LeCun周四证实, 他已创办一家新创企业 ——这是科技界人尽皆知的秘密——但他表示不会以首席执行官身份运营这家新公司。

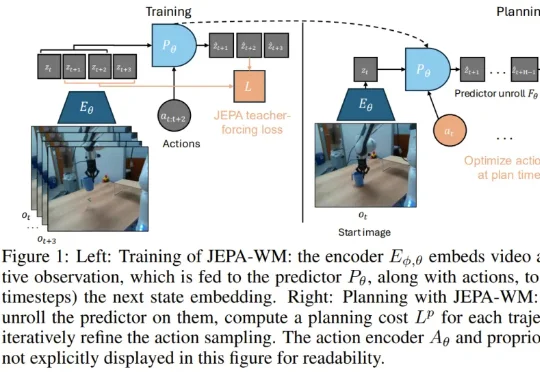

就在刚刚,即将离职 Meta 的图灵奖得主 Yann LeCun 在 Threads、领英等社交平台上宣布已经开启事业的下一阶段:创业。

上周,来自 Anthropic 的研究人员表示,他们最近观察到“首个由 AI 协同操作的网络攻击行动”,在一次针对数十个目标的攻击活动中,他们检测到有黑客使用该公司的 Claude AI 工具参与行动。不过,外部研究人员对 Anthropic 这一发现的评价要谨慎得多。

这是一个人类 AI 群星闪耀时的时刻——黄仁勋、李飞飞、杰弗里·辛顿(Geoffrey Hinton)、约书亚·本吉奥(Yoshua Bengio)、杨立昆(Yann LeCun)、比尔·戴利(Bill Dally),罕见同台参与同一个圆桌讨论 AI。之所以能聚在一起,是因为他们六人获得了 2025 年伊丽莎白女王工程奖。

我惊! 图灵奖得主、AI三巨头之一的LeCun在Meta待得是如坐针毡。 Yann LeCun已经直接跟同事表示,自己可能会辞去FAIR首席科学家的职务。

上周,福布斯、Wired等争相报道「全球最快开源推理模型」K2-Think,,甚至图灵奖得主Yann LeCun转发推文。但仅三天后,ETH五位研究员的博客如晴天霹雳:87数学评估题竟藏在训练集中!这不仅仅是技术突破,更是行业诚信的警钟。

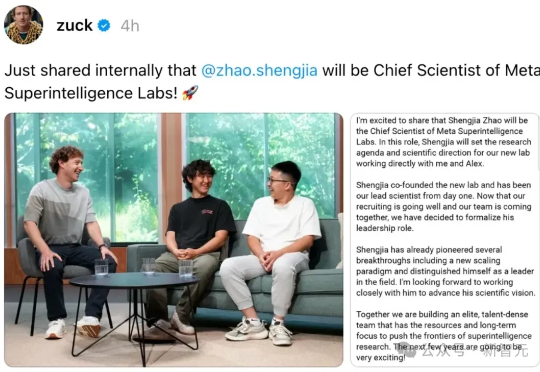

Meta超级智能实验室一拆四以后,首席AI官Alexandr Wang全员信曝光。这位28岁华人获扎克伯格力挺,出任超级智能实验室负责人。内部信强调「超级智能即将到来」,并宣布实验室拆分为四大部门。同时,AGI Foundations团队被解散,成员分流。Yann LeCun地位明显降级,权力重心全面向Wang集中。

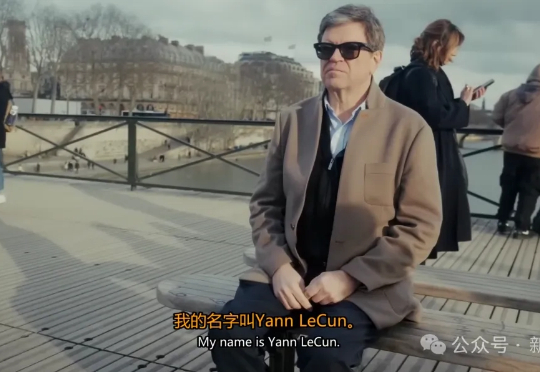

Yann LeCun的AI故事,纪录片回顾了这位深度学习先驱的四十年历程。从索邦大学的孤独探索,到贝尔实验室发明卷积神经网络、推动支票识别商用,再与Hinton、Bengio共创深度学习革命,他始终坚信机器应学会学习。